61 lines

4.0 KiB

Markdown

61 lines

4.0 KiB

Markdown

|

|

---

|

|||

|

|

title: Logistic Regression

|

|||

|

|

localeTitle: Logistic回归

|

|||

|

|

---

|

|||

|

|

## Logistic回归

|

|||

|

|

|

|||

|

|

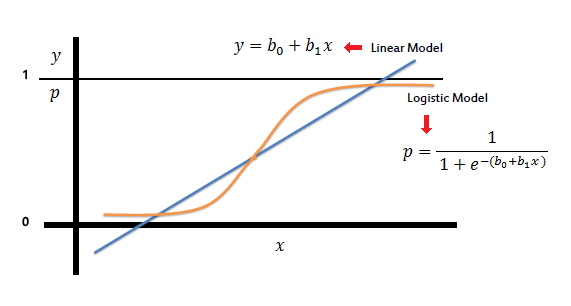

Logistic回归非常类似于线性回归,因为它尝试在给定一组X输入变量的情况下预测响应变量Y.它是一种监督学习形式,它试图通过首先用标记数据训练来预测未标记的,看不见的数据的响应,这是对独立(X)和从属(Y)变量的一组观察。但是,虽然[线性回归](https://guide.freecodecamp.org/machine-learning/linear-regression)假设响应变量(Y)是定量的或连续的,但当响应变量是定性的或离散的时,Logistic回归特别使用。

|

|||

|

|

|

|||

|

|

#### 怎么运行的

|

|||

|

|

|

|||

|

|

Logistic回归模拟响应变量Y属于某个类别的概率。在许多情况下,响应变量将是二进制变量,因此逻辑回归将要模拟函数y = f(x),该函数输出一个归一化值,对于X的所有值,范围从0到1,对应于Y的两个可能值。它通过使用逻辑函数来实现: 当因变量是二分的时(二元),逻辑回归是进行适当的回归分析。与所有回归分析一样,逻辑回归是预测分析。逻辑回归用于描述数据并解释一个从属二元变量与一个或多个名义,序数,区间或比率级别自变量之间的关系。

|

|||

|

|

|

|||

|

|

Logistic回归用于解决分类问题,其中输出的形式为y∈{0,1}。这里,0是负类,1是正类。假设我们有一个假设hθ(x),其中x是长度为m的数据集(矩阵)。 θ是参数矩阵。我们有:0 <hθ(x)<1

|

|||

|

|

|

|||

|

|

在Logistic回归中,hθ(x)是S形函数,因此hθ(x)= g(θ'x)。 g(θ'x)= 1/1 + e ^( - θ'x)

|

|||

|

|

|

|||

|

|

注意:θ'是θ转置。

|

|||

|

|

|

|||

|

|

#### 成本函数

|

|||

|

|

|

|||

|

|

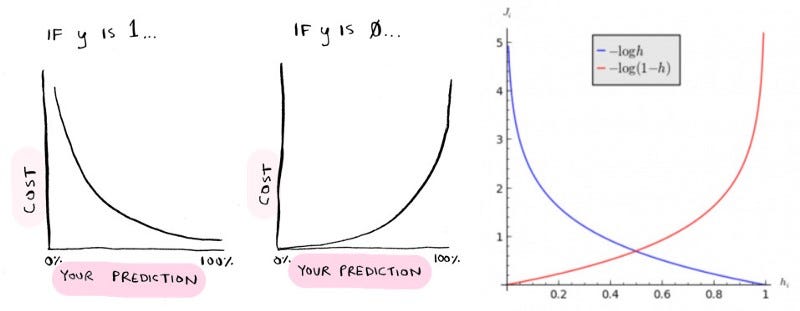

用于Logistic回归的成本函数是:

|

|||

|

|

|

|||

|

|

J(θ)=(1 / m)ΣCost(hθ(x(i)),y(i)),其中求和是从i = 1到m。

|

|||

|

|

|

|||

|

|

如果y = 1,则成本(hθ(x),y)= - log(hθ(x)) 如果y = 0,则成本(hθ(x),y)= - log(1-hθ(x))

|

|||

|

|

|

|||

|

|

#### 使用逻辑回归的预测:

|

|||

|

|

|

|||

|

|

Logistic回归模拟默认类(即第一类)的概率。 您可以对以下给出的结果进行分类:

|

|||

|

|

|

|||

|

|

y = e ^(b0 + b1 _X)/(1 + e ^(b0 + b1_ X))

|

|||

|

|

|

|||

|

|

类似于sigmoid函数0.5被设置为决策边界所有x,其中y≥0.5被分类为A类,并且y <0.5被分类为B类。

|

|||

|

|

|

|||

|

|

#### 多类逻辑回归:

|

|||

|

|

|

|||

|

|

虽然您会看到通常在二进制分类的情况下使用逻辑回归,但您也可以在以下情况下使用它来分类为多个类:

|

|||

|

|

|

|||

|

|

##### 一对一方法:

|

|||

|

|

|

|||

|

|

这里,每个类的分类器分别创建,分数最高的分类器被视为输出。

|

|||

|

|

|

|||

|

|

##### 一对一的方法:

|

|||

|

|

|

|||

|

|

这里制作多个(N \* N(N-1)/ 2,其中N =没有类)二进制分类器,然后通过比较它们的分数来获得输出。

|

|||

|

|

|

|||

|

|

#### 逻辑回归的应用:

|

|||

|

|

|

|||

|

|

1)将邮件归类为垃圾邮件或非垃圾邮件。 2)根据症状和其他医学数据确定某些疾病如癌症的存在与否。 3)基于像素数据对图像进行分类。

|

|||

|

|

|

|||

|

|

#### Logistic回归假设

|

|||

|

|

|

|||

|

|

二元逻辑回归要求因变量为二进制。 对于二元回归,因变量的因子级别1应表示期望的结果。 只应包含有意义的变量。 独立变量应该彼此独立。也就是说,模型应该具有很少或没有多重共线性。 自变量与对数几率线性相关。 Logistic回归需要非常大的样本量。

|

|||

|

|

|

|||

|

|

#### 更多信息:

|

|||

|

|

|

|||

|

|

为了进一步阅读,逐步建立逻辑回归:

|

|||

|

|

|

|||

|

|

* 单击[此处](https://medium.com/towards-data-science/building-a-logistic-regression-in-python-step-by-step-becd4d56c9c8)获取有关在Python中构建Logistic回归的文章。

|

|||

|

|

* 单击[此处](http://nbviewer.jupyter.org/gist/justmarkham/6d5c061ca5aee67c4316471f8c2ae976)获取有关构建逻辑回归的另一篇文章。

|

|||

|

|

* 点击[此处](http://nbviewer.jupyter.org/gist/justmarkham/6d5c061ca5aee67c4316471f8c2ae976)查看另一篇关于逻辑回归背后的数学和直觉的文章。

|